- Cisco Community

- シスコ コミュニティ

- データ センター

- [TKB] データセンター ドキュメント

- [HCI with Nutanix] C220/C240 M6/M7 マザーボード交換手順(ISM)

- RSS フィードを購読する

- 新着としてマーク

- 既読としてマーク

- ブックマーク

- 購読

- 印刷用ページ

- 不適切なコンテンツを報告

- RSS フィードを購読する

- 新着としてマーク

- 既読としてマーク

- ブックマーク

- 購読

- 印刷用ページ

- 不適切なコンテンツを報告

2024-10-21 06:44 PM 2024-10-24 02:25 PM 更新

本ドキュメントでは、HCI with Nutanix クラスタにおいての C220/C240 M6/M7 のマザーボード交換手順を説明いたします。

なお、ISM (Intersight Standalone Mode) 構成が対象となります。

[パーツ手配時の注意点]

- CPU と ヒートシンクは一緒に移設できるため、グリースやクリーニングキットの手配は不要です。

- TPM (Trusted Platform Module) を搭載している場合、TPM は交換後に載せ替えが出来ないため、筐体(マザーボード)交換の度に手配する必要があります。

TPM が搭載されているかどうか、CIMC の Technical support data を確認します。

\tmp の tech_support の Querying All IPMI Sensors、及び tech_support.frupids から判断可能です。<例:C220M6> 【搭載されていない場合】 ### tech_support ログ Querying All IPMI Sensors: FM_TPM_CARD_PRS | disc -> | discrete | 0x0180 | na | na | na | na | na | na | P1_CORE_VRHT | disc -> | discrete | 0x0180 | na | na | na | na | na | na | ### tech_support.frupids ログ FRU Device Description : FRU_TPM (ID 3) Device not present (Requested sensor, data, or record not found) 【搭載されている場合】 ### tech_support ログ Querying All IPMI Sensors: FM_TPM_CARD_PRS | disc -> | discrete | 0x0280 | na | na | na | na | na | na | P1_CORE_VRHT | disc -> | discrete | 0x0180 | na | na | na | na | na | na | ### tech_support.frupids ログ FRU Device Description : FRU_TPM (ID 3) Board Mfg : Cisco Systems Inc Board Product : UCSX-TPM2-002B-C Board Serial : FCHxxx

[作業前確認]

(FE 作業)

- (オプション、AHVの場合は不要)TPM Recovery Keyのバックアップ

TPMがインストールされていて、且つ、ESXi 7.0U2 以降をご利用の場合、TPM 交換後に ESXi が起動しなくなることがあります。 その場合に ESXi の復旧にリカバリーキーが必要ですので、リカバリーキーを控えておきます。# esxcli system settings encryption recovery list 以下記事もご参考ください。

[UCS] TPM 交換前に ESXi リカバリーキーをバックアップする必要性について - 旧サーバ S/Nの確認

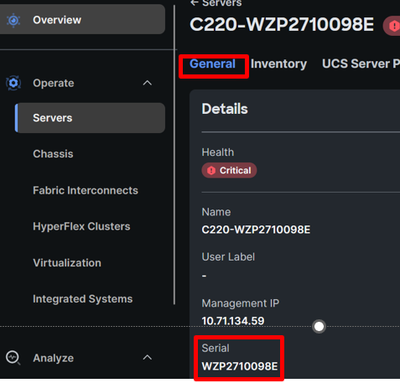

Interisightにログインし、 Infrastructure Service > Operate > Servers で対象サーバを選択し、S/Nをメモします。 - CIMC管理情報の確認

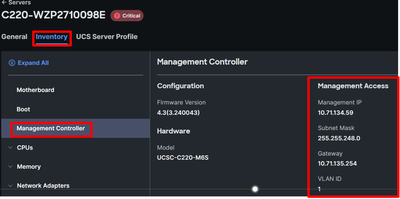

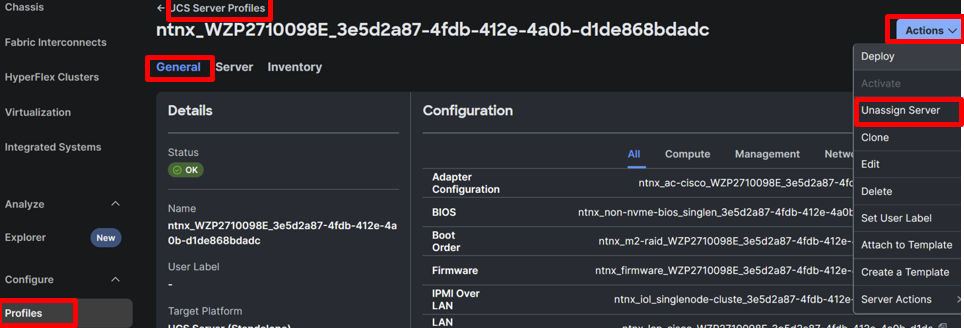

交換後にCIMCの初期設定が必要のため、事前に管理情報(IP address, Netmask, GW, VLAN)をメモします。 - Server Profile名の確認

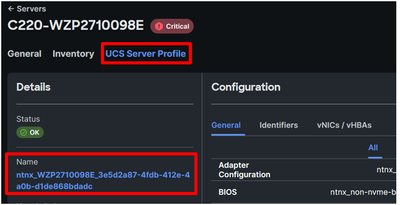

現在適用されたServer Profile名をメモします。 (Server Profile名は“ntnx_(serial_num_of_old_mobo)_(UUID)”となっている) - F/W バージョンの確認

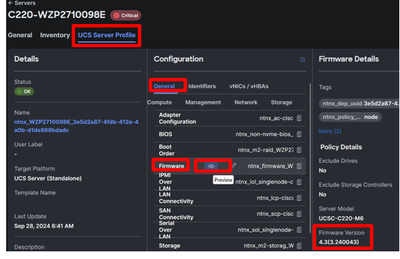

現在のFirmwareバージョンをメモします。

[交換手順]

-

Node shutdown

(お客様作業)

※作業対象のホスト上で動作している仮想マシンを、別のホストへ移動しておきます。

AHVの場合、以下を実施します。

1-1. 任意のController VMにssh接続し、「acli host.list」コマンドを実行し、対象HypervisorのIPをメモします。1-2. 以下のコマンドでmaintenance modeに移行します。

# acli host.enter_maintenance_mode [Hypervisor-IP-address] wait=true *[Hypervisor-IP-address]は対象HypervisorのIPと入れ替えてください。「acli host.get host-ip」CLIでmaintenance modeに移行したかをチェックします。

maintenance modeに移行後にnode_state:EnteredMaintenanceMode、schedulable: Falseとなります。

補足: 上記コマンドに wait 以外、non_migratable_vm_action のオプションパラメータもあります。

wait: メンテナンスモードに設定した際に、ライブマイグレーションを行うまで、待つかどうかを指定します。trueかfalseで指定し、デフォルトはtrueです。

non_migratable_vm_action: マイグレーションができない仮想マシンが存在した場合にどのようなアクションをするかの指定を行います。'block', 'acpi_shutdown'から選択し、デフォルトはblockです。

1-3. 以下コマンドでController VMをshutdownします。# cvm_shutdown -P now暫く待って、対象AHV Hostにsshし、下記のコマンドでVMがリストされていないことを確認します。

# virsh list

補足:AHVのNode shutdown方法について、以下資料があります。

Shutting Down a Node in a Cluster (AHV)

vSphereの場合、以下資料を参照し、maintenance mode移行、Controller VMのshutdownをご実施ください。

Shutting Down a Node in a Cluster through the vSphere Client -

ロケータ LED 点灯

(お客様作業)作業対象特定のために、CIMCの以下のメニューで[ロケータLED] を点灯してください。

- Server ProfileをUnassign

(FE 作業)

対象Server ProfileをUnssignします。

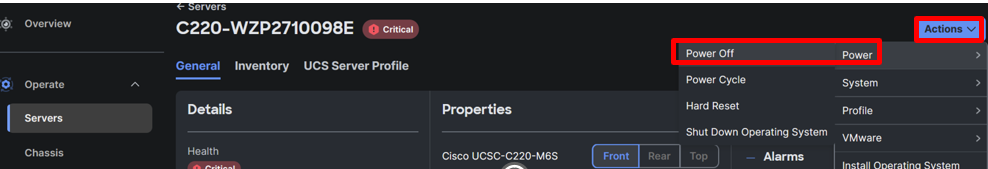

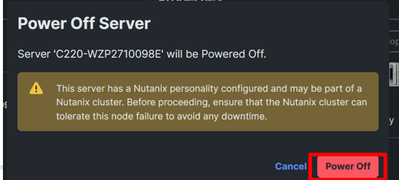

- ServerをPower OFF

(FE 作業)

対象サーバをPower Offします。

- ServerをUnclaim

(FE 作業)

System > Admin > Targetsに移動し、対象サーバをUnclaimします。 - マザーボードを交換

(FE 作業)

6-1. 新マザーボードのS/Nをメモします。

6-2. ケーブルやディスクなどのパーツを同じ場所へ接続・搭載できるように、マーキングをしてください。

6-3. サーバ背面の電源ケーブルやネットワークケーブルを全て抜きます。

6-4. サーバをラックから引き出します。

6-5. 以下の図を参考に②のロックを開放し、そのまま①のラッチを引き上げて天板を外します。

6-6. 搭載されているパーツを、全て新しいサーバの筐体へ載せ替えます。

6-7. (オプション)TPM を手配している場合は、新しいTPMを装着します。

6-8. 天板を元に戻し、新しいサーバの筐体をラックに戻します。

6-9. サーバ背面のネットワークケーブルを元の通りに接続します。その後、電源ケーブルを元の通りに接続します。 - CIMCの初期設定

(FE 作業)7-1. キーボードとディスプレイをサーバに接続します。

7-2. 電源ボタンを押して、サーバを起動させます。

7-3. 以下の起動画面時にF8キーで CIMC の設定画面に入ります。一通り処理が終わるまで、CIMC 設定画面へは移行しません。7-4. CIMCの設定画面にて、メモしたCIMC管理情報を設定します。

(FE 作業)

※NIC modeをDedicatedで、NIC redundancyをNoneで指定

- NIC mode:

- CIMC IP:

- Prefix/Subnet:

- Gateway:

- NIC redundancy:参考資料:[UCS] UCS C-Series サーバーのCIMC初期設定方法について

7-5. IP で CIMC GUI へアクセスできることを確認します。 - Intersightにサーバ再登録

(FE 作業)

お客様からデバイスコネクタの設定情報をいただき([2. CIMCの設定確認] ステップでのメモ)、以下のドキュメントを参照して、サーバをIntersightへ登録します。[Intersight] Intersightに登録(Direct Claim)したサーバのRMA後のデバイスコネクタ再登録について

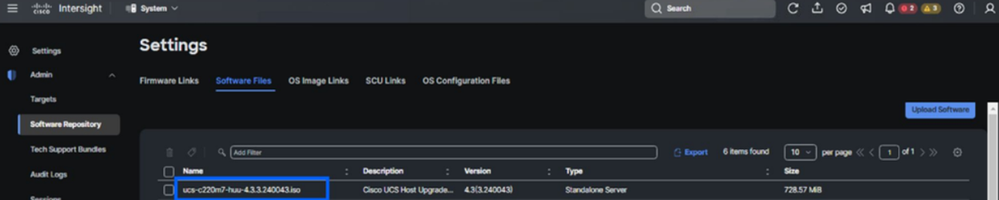

https://community.cisco.com/t5/-/-/ta-p/4536945 - F/W Filesの確認 (※PVA Intersightのみの場合)

(FE 作業)

System > Admin > Software Repository > Software Filesに移動し、対象のHUU ISOファイルが存在するかを確認します。存在しない場合、[Upload Software]でファイルをアップロードします。

補足:弊社ダウンロードサイトより対象のHUU ISOファイルをダウンロード出来ます。

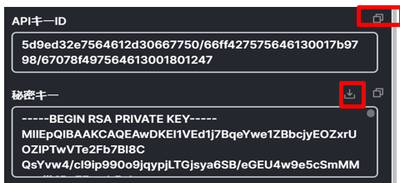

https://software.cisco.com/download/home - API Key IDとSecret Key fileの生成

(お客様作業)

後述のPersonality Re-stamp作業の実施にIntersightのAPI Key IDとSecret Key fileが必要です。既存のAPI ID/Secret pairを利用可能で、新たに生成しても問題ありません。

*現状API Key schema version 2 がサポートされます。

生成手順について、以下資料の[Intersight API Key の取得]の内容をご参照ください。

https://community.cisco.com/t5/-/-/ta-p/4891953#toc-hId-1698022754

API Key IDをメモします。

Secret Keyをファイルでダウンロードし、ZooKeeper (zk) leader CVMの/tmp配下にコピーしてください。

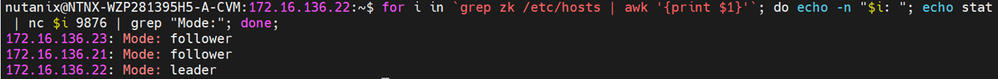

補足:ZooKeeper (zk) leader CVMの確認について、任意のCVMにssh接続し、以下コマンドで特定可能です。#for i in `grep zk /etc/hosts | awk '{print $1}'`; do echo -n "$i: "; echo stat | nc $i 9876 | grep "Mode:"; done;

[Personality Re-stamp作業]

(TAC作業)

Personality Re-stampスクリプトで新サーバに対して以下のPersonality Re-stamp作業を実施します。Personality Re-stampスクリプトは以下内容の実施に作成されたPythonスクリプトです。

- 新サーバのIntersight上のServer Personality 項(Servers > 該当サーバ > General > Server Personality)をNutanix HCI Nodeに更新

- 新サーバに対して、Policiesと「ntnx_serial_num_of_new_motherboard_UUID」という名前のServer Profileの作成

- 新サーバにServer Profileの適用

- F/Wバージョン異なる場合、Firmware Policy設定でバージョンあわせる

弊社より該当スクリプトを送付しますが、受領後にZooKeeper (zk) leader CVMの/tmp配下にコピーしてください。なお、TACによる本Personality Re-stamp作業を実施します。

[Nutanix関連作業]

(TAC作業)

Personality Re-stamp作業を完了し、Maintenance Modeを解除し、その後、NutanixのCVM にてS/N更新、及びClusterのヘルスチェックを実施する必要があります。作業実施については、TACにご連絡ください。

検索バーにキーワード、フレーズ、または質問を入力し、お探しのものを見つけましょう

シスコ コミュニティをいち早く使いこなしていただけるよう役立つリンクをまとめました。みなさんのジャーニーがより良いものとなるようお手伝いします

下記より関連するコンテンツにアクセスできます